情報エントロピーとプログラミング

情報エントロピーとプログラミングについて解説します。情報エントロピーとは何か、どのようにプログラミングで使われるか、そしてその応用について詳しく説明していきます。情報エントロピーは、難しそうに感じるかもしれませんが、実はデータの不確実性を測る概念で、情報科学や機械学習など、現代のさまざまな分野で重要な役割を果たしています。

情報エントロピーとは?

情報エントロピーは、1948年に数学者クラウド・シャノンによって提唱された概念です。エントロピーという言葉自体はもともと熱力学で用いられ、エネルギーの分散や無秩序さを表すためのものでした。しかし、シャノンはこの概念を情報の分野に応用し、情報の不確実性や予測困難性を表すために使いました。つまり、情報エントロピーは「ある情報がどれだけ予測しにくいか」を示す指標です。

例えば、コイントスを例に考えてみましょう。コインを投げたとき、表か裏のどちらかが出ますが、その結果を完全に予測することはできません。このように、結果がランダムで予測が難しいほど、エントロピーは高くなります。一方、全てが確定しているような状況ではエントロピーは低くなります。

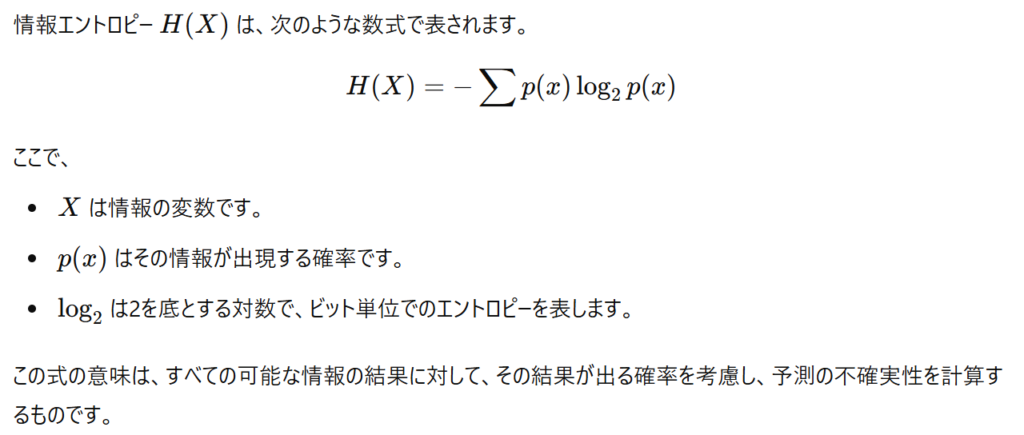

情報エントロピーの数式

プログラミングでの情報エントロピーの活用

情報エントロピーの概念は、プログラミングのさまざまな分野で役立てられています。具体的には、データ圧縮、暗号化、機械学習など、データの扱い方や解析において重要な役割を果たします。

1. データ圧縮

データ圧縮の分野では、情報エントロピーが「データの冗長性」を減らすための指標として使われます。情報エントロピーが高いデータは、多様な情報が含まれているため、圧縮が難しい傾向があります。一方、エントロピーが低いデータは冗長性が多く、圧縮が容易です。

例えば、テキストファイルで「aaaaaa」という内容が続いている場合、内容が繰り返しのため、エントロピーが低くなります。このような場合、「aを6回繰り返す」という情報に置き換えることで、データサイズを減らせます。これはランレングス符号と呼ばれる簡単な圧縮方法です。

2. 機械学習でのエントロピー

機械学習においても、情報エントロピーは重要です。特に分類問題で使われる決定木では、情報エントロピーを用いてデータを最適に分割する基準を定めています。

決定木の学習において、エントロピーが最も低くなるようなデータ分割が理想的です。これにより、決定木は効率的に分類を行うことができます。具体的には、エントロピーの低い状態を目指して、情報の「純度」を高め、クラス分けがしやすいように調整します。

情報エントロピーをPythonで計算してみよう

情報エントロピーの計算をPythonで実際にやってみましょう。Pythonには、情報エントロピーを計算するための便利なライブラリがいくつかありますが、ここでは基本的なコードで計算方法を示します。

import math

# エントロピーを計算する関数

def calculate_entropy(probabilities):

entropy = -sum([p * math.log2(p) for p in probabilities if p > 0])

return entropy

# 例: ある変数が取る確率

probabilities = [0.5, 0.5] # コイントスの場合、表と裏がそれぞれ50%

entropy = calculate_entropy(probabilities)

print(f"情報エントロピー: {entropy} ビット")

このコードでは、コインの表と裏の出る確率が50%ずつの場合のエントロピーを計算しています。出力は「1ビット」となり、これは二進数で1つの情報が必要であることを意味します。

実際の応用例

例えば、自然言語処理(NLP)において、エントロピーは単語の出現確率に基づいて計算されます。この計算により、文章の多様性や予測難易度を評価することが可能です。

情報エントロピーのメリットとデメリット

メリット

- データの圧縮効率を向上:冗長なデータを見極め、効率的な圧縮が可能。

- 予測精度の向上:機械学習において、エントロピーが低いほどデータの分類がしやすくなる。

- データ解析の基盤:エントロピーを基にした解析が、データの特徴を把握しやすくする。

デメリット

- 計算量が増える:多くのデータに対してエントロピーを計算すると、計算コストが高くなる場合がある。

- 単純化される情報もある:特に複雑なデータに対しては、エントロピーだけでは十分な分析ができないことがある。

今後の学習の指針

情報エントロピーは、情報量を測るための基本概念として非常に有用です。データの性質や予測困難性を理解することは、プログラミングの効率化やアルゴリズムの最適化に大きく役立ちます。さらに進んだ学習では、エントロピーの応用としてクロスエントロピーや相互情報量などの概念も学ぶと良いでしょう。これらは特に、深層学習や統計的学習の分野で頻繁に使われています。

セイ・コンサルティング・グループの新人エンジニア研修のメニューへのリンク

投稿者プロフィール

- 代表取締役

-

セイ・コンサルティング・グループ株式会社代表取締役。

岐阜県出身。

2000年創業、2004年会社設立。

IT企業向け人材育成研修歴業界歴20年以上。

すべての無駄を省いた費用対効果の高い「筋肉質」な研修を提供します!

この記事に間違い等ありましたらぜひお知らせください。

学生時代は趣味と実益を兼ねてリゾートバイトにいそしむ。長野県白馬村に始まり、志賀高原でのスキーインストラクター、沖縄石垣島、北海道トマム。高じてオーストラリアのゴールドコーストでツアーガイドなど。現在は野菜作りにはまっている。